Avez-vous essayé d’éviter l’installation de Windows 10 ? Il vous faudra une bonne dose de patience. Pourquoi cette insistance de la part de Microsoft ? Certes, la firme de Redmond a changé de modèle économique pour transiter vers un système d’abonnement et de revente des données. Mais ce bouleversement de business model doit être vu dans son ensemble.

Avec Windows 10, Microsoft vous offre Cortana. Cortana est votre assistant, chargé de répondre à vos moindres attentes… en apprenant de vous.

Vous avez aussi un téléphone Android. Avec lequel vous utilisez les services de Google Now en le hélant d’un familier « OK Google ! »

Après la lecture de cet article, vous allez immédiatement en parler avec vos amis, sur le Messenger de Facebook, au sein duquel réside « M », un autre assistant.

Les années 2000 ont été celles aux milliers d’amis (sur Facebook). Celles qui viennent seront celles des dizaines d’assistants (virtuels, eux aussi). Évidemment, l’aide qu’ils vous apporteront serait plus pertinente s’il n’y en avait qu’un, qui aurait accès à vos données que vous utilisiez votre PC, votre téléphone pour surfer dans le métro ou que vous soyez sur votre réseau préféré.

C’est également l’avis de Microsoft, Google, Facebook, Apple, Amazon, etc. qui cherchent à vous convaincre de la pertinence des services rendus par leur assistant : Le coup d’envoi de la course à l’intelligence artificielle (IA) est donné, elle est prête à être visible dans nos vies. Avec la généralisation des réseaux hauts débits, les échanges de données massifs sont possibles sans altérer le service rendu à l’utilisateur. Les méthodes de calcul ont été affinées pour les analyser et les processeurs sont suffisamment puissants pour le faire en temps réel.

Ce saut technologique entraîne une révolution. Comparons deux champions à vingt ans d’intervalle.

Après Deep Blue battant Gary Kasparov aux échecs en 1997, le logiciel AlphaGo de Google est devenu célèbre en obtenant la victoire en 2016 face au Coréen Lee Sedol, un des meilleurs joueurs mondiaux de go, se plaçant lui-même à la quatrième place au classement mondial.

L’écrivain Shen Lei a présenté cette défaite comme celle « du dernier des guerriers ».

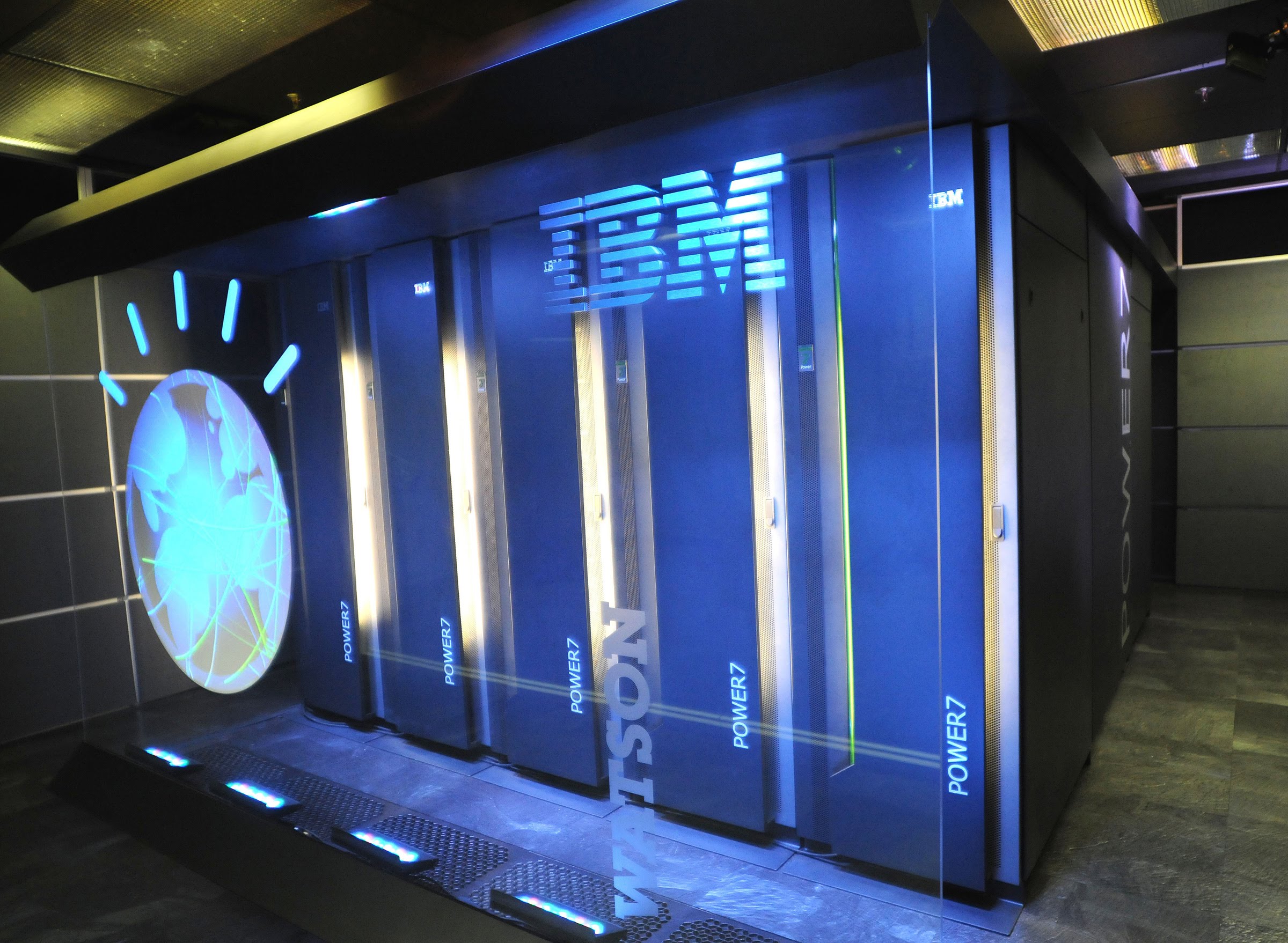

La réalité, qui ne cède en rien à la fiction, est toute autre. AlphaGo, très doué pour le Go, aurait du mal à entamer une conversation ou à se déplacer dans un labyrinthe. Dans l’immédiat. Car les algorithmes d’AlphaGo sont plus évolués que ceux de son « ancètre » Deep Blue. Ce dernier était un supercalculateur spécialisé dans le jeu d’échecs. Le matériel lui-même était ultra-spécialisé : 32 processeurs dédiés au calcul pur et 8… dédiés aux échecs. Deep Blue n’aurait pas pu apprendre le go.

Aujourd’hui, AlphaGo combine les dernières innovations en termes d’apprentissage. Il allie la recherche Monte-Carlo, l’apprentissage profond (deep learning) et l’analyse massive de données.

La méthode de Monte-Carlo consiste à établir des statistiques sur des coups possibles à partir de parties (presque) aléatoires. L’apprentissage profond est une technique d’abstraction des données par des couches successives de traitement à base de réseaux de neurones.

La force d’AlphaGo est de combiner ces deux méthodes, en générant des coups avec l’apprentissage profond, qu’il testera dans les parties « aléatoires ». La méthode de Monte-Carlo évalue la proposition de jeu.

L’analyse massives de données complète le tableau avec le traitement de volumes importants de données. Dans un premier temps, des données issues de parties de grands joueurs, puis, celles issues des parties qu’AlphaGo jouera… contre lui-même. Le principe de ce dernier type d’entraînement est de mettre en compétition deux instances du programme afin que ce dernier s’entraîne au cours de millions de parties contre un joueur qui atteint un niveau mondial : lui-même.

Un nom n’est pas cité dans les derniers paragraphes. C’est celui du jeu lui-même, le go. La différence majeure avec les logiciels d’IA d’il y a vingt ans, c’est que la nouvelle génération est adaptable. AlphaGo est devenu en quelques années un champion de go. Il pourra devenir demain champion d’échecs. Il sera en mesure de s’imposer dans toute activité pour laquelle il existe un cadre de règles strictes. Les algorithmes créés pourront également être utiles pour des activités mêlant logique et interactions humaines, telles que l’assistance aux diagnostiques.

Google a lui aussi créé ses propres processeurs, mais ceux-ci sont destinés à améliorer les performances des algorithmes d’apprentissage, qu’ils soient destinés à jouer au go, à la reconnaissance vocale ou au traitement de vos mails.

Que restera-t-il aux humains ? Pour Zhongheng Zhang « Tous les travaux soumis à des règles pourront être réalisés par des machines et les humains devront se contenter du domaine de l’émotion » (1).

Cette omniprésence de l’IA sera-t-elle un danger, ainsi que l’anticipent Elon Musk et Stephen Hawking ?

Sans aller jusqu’à agiter le spectre d’une révolution des logiciels cherchant à éliminer les humains, nous aurons à faire face à un problème jamais rencontré. Nous allons créer des systèmes intelligents. Leur intelligence ne sera certainement pas similaire, par sa nature, à la notre. Mais étant capable d’évoluer à un rythme bien supérieur, l’expression de cette intelligence parviendra sûrement au même niveau.

Un logiciel aussi évolué gérera des machines de taille respectable ou des systèmes contrôlant des niveaux d’énergie importants. Pour devenir intelligent, il aura du apprendre, et pour apprendre, il aura du se tromper. Pas d’apprentissage sans droit à l’erreur. Ce qui signifie que les systèmes intelligents de demain seront des systèmes faillibles. Infiniment moins que vous ou moi, car ils auront eu l’occasion de s’entraîner des millions de fois. Mais faillibles tout de même.

Puisqu’ils devront prendre des décisions, il leur faudra un minimum de liberté.

Nous vivrons avec des systèmes possédant des degrés de libertés, avec une probabilité très faible de nuisance, mais, au cas où un incident survienne, un impact potentiellement important. Donc, des systèmes à haut risque.

Un chercheur de DeepMind et un philosophe tentent d’apporter une solution en voulant mettre en place un « bouton rouge » logiciel, commandant l’arrêt du programme en cas de mise en danger (2). Car pour qu’ils puissent s’adapter à de multiples besoins, les robots ne seront plus programmés directement à une tâche, mais à obtenir des « points » de satisfaction quand ils réalisent cette tâche. Imaginons maintenant qu’un de ces robot soit placé sous la tutelle d’un humain pour garantir la sécurité.

[…] L’article dans son intégralité est paru dans Planète Robots n°41 du 1er Septembre 2016.